La censure algorithmique est devenue un sujet de préoccupation majeur dans notre société numérique. À mesure que les plateformes en ligne développent des systèmes automatisés pour filtrer les contenus, les questions juridiques se multiplient. Entre protection des libertés fondamentales et nécessité de modération, un équilibre délicat doit être trouvé. Les législateurs du monde entier tentent d’élaborer des cadres réglementaires adaptés, tandis que les tribunaux commencent à établir une jurisprudence sur ces questions. Ce phénomène soulève des interrogations fondamentales sur la gouvernance d’internet et la responsabilité des acteurs numériques.

Les Fondements Juridiques Face à la Modération Automatisée des Contenus

La censure algorithmique s’inscrit dans un cadre juridique complexe où s’entrechoquent plusieurs principes fondamentaux. En France et en Europe, la liberté d’expression consacrée par l’article 11 de la Déclaration des Droits de l’Homme et du Citoyen et l’article 10 de la Convention Européenne des Droits de l’Homme constitue le socle de référence. Toutefois, cette liberté n’est pas absolue et doit se concilier avec d’autres droits comme la protection de la dignité humaine ou la lutte contre les discours haineux.

Le Règlement sur les Services Numériques (DSA) adopté par l’Union Européenne en 2022 marque une avancée significative dans l’encadrement de la modération algorithmique. Ce texte impose aux plateformes une transparence accrue sur leurs systèmes de filtrage automatisé et établit des garanties procédurales pour les utilisateurs dont les contenus sont supprimés. La notion de « diligence proportionnée » y est centrale, obligeant les opérateurs à mettre en œuvre des moyens proportionnés à leur taille et à l’impact potentiel des contenus qu’ils hébergent.

En France, la loi pour la confiance dans l’économie numérique (LCEN) de 2004 reste un texte fondateur, bien qu’antérieur à l’essor des algorithmes de modération. Elle distingue le régime d’hébergeur de celui d’éditeur, une dichotomie mise à l’épreuve par les systèmes de recommandation et de filtrage automatisés. La loi Avia, partiellement censurée par le Conseil Constitutionnel en 2020, illustre la difficulté à légiférer sur ces questions sans porter atteinte aux libertés fondamentales.

Sur le plan international, les approches divergent considérablement. Aux États-Unis, le Premier Amendement et la section 230 du Communications Decency Act offrent une protection extensive aux plateformes, tandis que des pays comme la Chine ou la Russie ont développé des cadres juridiques facilitant une censure étatique via les outils algorithmiques.

Évolution de la jurisprudence

Les tribunaux commencent à façonner une jurisprudence spécifique aux questions de censure algorithmique. L’arrêt CJUE Google Spain de 2014 sur le droit à l’oubli a posé les premiers jalons d’une responsabilité des plateformes dans le traitement algorithmique des informations. Plus récemment, des décisions comme celle du Tribunal de grande instance de Paris concernant Twitter en 2022 ont reconnu l’obligation pour les plateformes de justifier précisément leurs décisions de modération automatisée.

- Reconnaissance progressive du droit à l’explication des décisions algorithmiques

- Émergence d’un droit de recours effectif contre les décisions automatisées

- Qualification juridique évolutive des systèmes de recommandation et de modération

Responsabilités Juridiques des Plateformes et Concepteurs d’Algorithmes

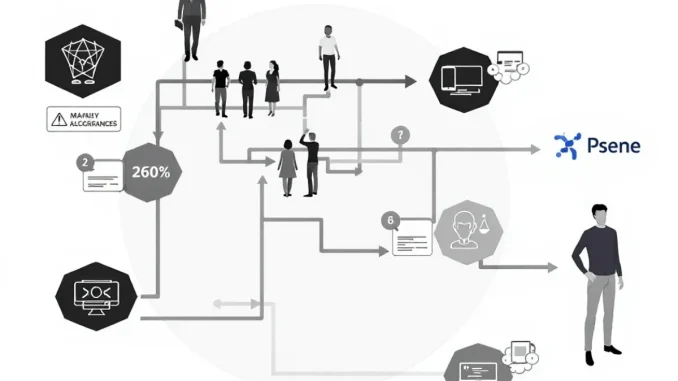

La question de la responsabilité juridique dans le cadre de la censure algorithmique soulève des défis conceptuels majeurs. Le statut d’intermédiaire technique dont bénéficient traditionnellement les plateformes numériques est progressivement remis en question face à leur rôle actif dans la sélection et la modération des contenus. Le DSA européen introduit une approche graduée, où les obligations augmentent proportionnellement à la taille et à l’influence de la plateforme, avec des exigences particulièrement strictes pour les « très grandes plateformes en ligne ».

La responsabilité des concepteurs d’algorithmes émerge comme un nouveau champ juridique. Les entreprises développant des outils de filtrage automatisé peuvent désormais être tenues responsables des biais ou des erreurs systémiques de leurs systèmes. Cette responsabilité s’articule autour de plusieurs obligations : une obligation de conception éthique, une obligation de test et d’évaluation préalable, et une obligation de suivi et de correction continue.

Le règlement sur l’Intelligence Artificielle proposé par l’Union Européenne en 2021 établit une classification des systèmes d’IA selon leur niveau de risque. Les algorithmes de modération de contenus y sont généralement considérés comme présentant un « risque élevé », ce qui implique des obligations renforcées en matière de transparence, de robustesse technique et de supervision humaine. Cette approche fondée sur les risques pourrait devenir un standard global.

La question de la responsabilité éditoriale des plateformes fait l’objet de débats juridiques intenses. Lorsqu’une plateforme utilise des algorithmes pour promouvoir certains contenus et en restreindre d’autres, agit-elle comme un simple hébergeur ou assume-t-elle un rôle éditorial? La Cour de cassation française a commencé à reconnaître une forme de responsabilité éditoriale pour les plateformes qui organisent et hiérarchisent les contenus de manière automatisée, comme l’illustre l’arrêt Google Suggest de 2012.

Le devoir de vigilance algorithmique

Un nouveau concept juridique émerge : le « devoir de vigilance algorithmique ». Inspiré de la loi française sur le devoir de vigilance des multinationales, ce principe imposerait aux plateformes une obligation de prévention des atteintes aux droits fondamentaux pouvant résulter de leurs systèmes algorithmiques. Cette approche préventive complète les mécanismes de responsabilité a posteriori et pourrait constituer un levier juridique puissant.

- Obligation d’audit régulier des systèmes algorithmiques

- Nécessité d’établir des procédures de signalement efficaces

- Mise en place de mécanismes de réparation pour les victimes de censure injustifiée

Transparence et Explicabilité des Décisions Algorithmiques de Censure

La transparence algorithmique est devenue un pilier central des efforts réglementaires concernant la censure automatisée. Le DSA européen impose aux plateformes de fournir des informations claires sur les paramètres principaux utilisés par leurs systèmes de recommandation et de modération. Cette exigence va au-delà d’une simple publication des conditions générales d’utilisation et requiert une explication substantielle des facteurs influençant les décisions de filtrage ou de retrait de contenus.

L’explicabilité des décisions algorithmiques constitue un défi technique et juridique majeur. Les systèmes d’intelligence artificielle les plus avancés, notamment ceux basés sur l’apprentissage profond, fonctionnent souvent comme des « boîtes noires » dont les décisions ne peuvent être facilement expliquées, même par leurs concepteurs. Cette opacité pose un problème fondamental au regard du droit à un recours effectif garanti par l’article 47 de la Charte des droits fondamentaux de l’Union européenne.

Le droit d’accès aux informations concernant la modération algorithmique se développe progressivement. En France, la CNIL a précisé que les décisions de modération automatisée tombent sous le coup des dispositions du RGPD relatives aux décisions individuelles automatisées (article 22). Cela implique, dans certaines circonstances, un droit d’opposition et d’explication pour les personnes concernées. Aux États-Unis, des États comme la Californie ont adopté des législations comparables avec le California Consumer Privacy Act.

Les obligations de notification des décisions de censure algorithmique se renforcent. Le DSA exige que les plateformes informent clairement les utilisateurs lorsque leurs contenus sont retirés ou leur visibilité réduite par des systèmes automatisés. Cette notification doit inclure les motifs de la décision et les voies de recours disponibles. Cette exigence représente une avancée significative par rapport au statu quo antérieur, où de nombreuses plateformes pratiquaient une modération silencieuse (« shadow banning ») sans information des utilisateurs concernés.

Les standards émergents d’audit algorithmique

Le développement de standards d’audit pour les systèmes de modération automatisée constitue une tendance majeure. Des organismes comme l’AFNOR en France ou l’ISO au niveau international travaillent à l’élaboration de normes techniques permettant d’évaluer l’équité, la transparence et la performance des algorithmes de censure. Ces standards pourraient devenir des références pour les régulateurs et les tribunaux.

- Méthodologies standardisées d’évaluation des biais algorithmiques

- Protocoles de documentation des systèmes de modération

- Indicateurs de performance et de fiabilité des décisions automatisées

Protection des Droits Fondamentaux Face aux Algorithmes de Modération

La censure algorithmique soulève des questions fondamentales quant à la protection effective de la liberté d’expression dans l’environnement numérique. Les systèmes automatisés tendent à appliquer des règles générales sans tenir compte des nuances contextuelles ou des exceptions légitimes comme la parodie, la citation ou le reportage journalistique. Cette approche peut conduire à un effet dissuasif (« chilling effect ») où les utilisateurs s’autocensurent par crainte d’une modération excessive.

Le pluralisme des opinions peut être menacé par des algorithmes de modération trop stricts ou mal calibrés. Des études menées par des chercheurs de l’Université de Stanford et du MIT ont démontré que certains systèmes de filtrage automatique pénalisent disproportionnellement les discours minoritaires ou utilisant des dialectes non standard. Cette discrimination algorithmique pose un problème majeur dans une société démocratique qui valorise la diversité des points de vue.

La protection de la dignité humaine et la lutte contre les discours haineux justifient l’utilisation d’algorithmes de modération, mais requièrent des garanties contre les excès. Le Conseil de l’Europe a élaboré en 2021 des lignes directrices soulignant la nécessité d’un équilibre entre la répression des contenus manifestement illicites et la préservation d’un espace de débat ouvert. Ces recommandations mettent l’accent sur le principe de proportionnalité et sur l’importance d’une supervision humaine des décisions algorithmiques les plus sensibles.

Le droit à un recours effectif face aux décisions de censure algorithmique s’affirme progressivement. Le DSA européen impose aux plateformes la mise en place de mécanismes de contestation internes facilement accessibles et efficaces. Au-delà, des voies de recours externes se développent, comme les procédures de médiation ou l’accès à des autorités indépendantes. En France, l’ARCOM commence à jouer un rôle dans la supervision des systèmes de modération des grandes plateformes.

L’émergence des « cours d’appel » privées

Un phénomène notable est l’apparition de mécanismes quasi-judiciaires privés pour examiner les décisions de modération contestées. Le Conseil de surveillance de Facebook (Oversight Board) constitue l’exemple le plus abouti de cette tendance. Composé d’experts indépendants, cet organe peut annuler les décisions de modération de la plateforme et établit une forme de jurisprudence interne. Ce modèle hybride, entre autorégulation et contrôle externe, pourrait se généraliser à d’autres plateformes.

- Développement de standards de « due process » dans la modération privée

- Émergence de garanties procédurales inspirées du droit public

- Articulation complexe entre ces mécanismes privés et le contrôle judiciaire traditionnel

Vers une Co-régulation Adaptée à l’Ère Algorithmique

Face aux défis posés par la censure algorithmique, un consensus émerge autour d’un modèle de co-régulation associant pouvoirs publics, plateformes privées et société civile. Cette approche reconnaît les limites tant de l’autorégulation pure, qui a montré ses insuffisances, que d’une réglementation étatique rigide, souvent inadaptée à la rapidité des évolutions technologiques. Le DSA européen incarne cette philosophie en combinant des obligations légales précises avec des mécanismes de régulation souples comme les codes de conduite sectoriels.

Le rôle des autorités administratives indépendantes se renforce dans la supervision des algorithmes de modération. En France, l’ARCOM et la CNIL développent une expertise conjointe sur ces questions. Au niveau européen, un réseau de régulateurs nationaux coordonnés par la Commission européenne se met en place pour assurer une application cohérente du DSA. Ces organismes disposent de pouvoirs croissants d’investigation et de sanction, pouvant atteindre jusqu’à 6% du chiffre d’affaires mondial des plateformes récalcitrantes.

L’implication de la société civile dans la gouvernance des systèmes de modération constitue une innovation majeure. Des organisations comme Algorithm Watch ou la Quadrature du Net jouent un rôle de contre-pouvoir en analysant les pratiques de modération et en alertant sur leurs dérives potentielles. Certaines plateformes commencent à intégrer formellement des représentants d’ONG dans leurs processus d’élaboration des règles de modération, comme l’illustre le Trust and Safety Council de Twitter (avant sa dissolution controversée en 2022).

La standardisation technique émerge comme un levier de régulation complémentaire. Des initiatives comme le Partnership on AI ou l’IEEE Global Initiative on Ethics of Autonomous and Intelligent Systems développent des référentiels techniques pour évaluer et améliorer les systèmes de modération automatisée. Ces standards volontaires peuvent ensuite être repris dans des cadres réglementaires contraignants, selon un mécanisme de « régulation par référence » déjà utilisé dans d’autres secteurs technologiques.

L’interopérabilité comme garantie contre la censure excessive

Un concept novateur gagne du terrain : l’utilisation de l’interopérabilité comme garde-fou contre les excès de la censure algorithmique. En permettant aux utilisateurs de migrer facilement d’une plateforme à une autre tout en conservant leurs connexions sociales, l’interopérabilité réduirait le pouvoir des grandes plateformes et favoriserait l’émergence d’espaces numériques aux politiques de modération diversifiées. Le Digital Markets Act européen contient des dispositions en ce sens pour les services de messagerie.

- Développement de protocoles ouverts pour les réseaux sociaux

- Portabilité effective des données et des relations sociales

- Émergence d’un écosystème de plateformes aux approches de modération diversifiées

Le Futur de la Régulation Algorithmique : Défis et Opportunités

L’avenir de la régulation de la censure algorithmique s’annonce complexe et dynamique. L’évolution rapide des technologies d’intelligence artificielle, notamment les modèles de langage avancés comme GPT-4 ou LLaMA, transforme profondément les capacités et les limites de la modération automatisée. Ces systèmes promettent une meilleure compréhension du contexte et des nuances linguistiques, mais soulèvent des questions inédites concernant leur transparence et leur contrôle démocratique.

La territorialité du droit face à des plateformes globales reste un défi majeur. L’effet extraterritorial du DSA européen, capable d’influencer les pratiques mondiales des géants du numérique, illustre l’émergence d’une forme de régulation par « effet Bruxelles ». Parallèlement, des initiatives comme le Forum sur la Gouvernance de l’Internet tentent d’établir des normes et principes transnationaux pour encadrer la modération de contenus, bien que leur portée juridique reste limitée.

L’évaluation d’impact algorithmique s’impose progressivement comme un outil réglementaire central. Inspirée des études d’impact environnemental, cette approche oblige les concepteurs de systèmes de modération à analyser en amont les effets potentiels de leurs algorithmes sur les droits fondamentaux et à mettre en œuvre des mesures d’atténuation des risques identifiés. Le Canada a été pionnier dans ce domaine avec sa Directive sur la prise de décision automatisée applicable au secteur public, un modèle qui pourrait s’étendre au secteur privé.

La question de la souveraineté numérique dans le domaine de la modération de contenus gagne en importance. Des pays comme la France ou l’Allemagne s’inquiètent de voir les normes culturelles et juridiques américaines s’imposer mondialement via les algorithmes des grandes plateformes. Des initiatives comme le développement d’alternatives européennes aux services numériques dominants ou la promotion de standards éthiques reflétant les valeurs européennes visent à rééquilibrer cette influence.

Vers une personnalisation du contrôle utilisateur

Une tendance prometteuse émerge : donner aux utilisateurs davantage de contrôle sur les algorithmes qui filtrent les contenus qu’ils consultent. Des plateformes comme Reddit ou Mastodon expérimentent des modèles où les utilisateurs peuvent choisir entre différentes politiques de modération ou même créer leurs propres espaces avec des règles spécifiques. Cette approche décentralisée pourrait concilier la nécessité d’une modération efficace avec le respect de la diversité des sensibilités et des contextes culturels.

- Développement d’interfaces permettant aux utilisateurs de paramétrer les algorithmes de filtrage

- Émergence de standards ouverts pour la modération communautaire

- Recherche sur les modèles hybrides combinant modération centralisée et choix utilisateur

La régulation de la censure algorithmique se trouve à la croisée de multiples enjeux juridiques, technologiques et démocratiques. Le cadre réglementaire qui émerge progressivement devra trouver un équilibre délicat entre la protection contre les contenus préjudiciables et la préservation d’un internet ouvert et pluraliste. Cette quête d’équilibre nécessitera une collaboration sans précédent entre législateurs, juges, ingénieurs et citoyens, dans un processus d’innovation juridique et technique continu.